קובץ ה robots.txt הוא הדרך העיקרית שלנו לתקשר עם מנועי החיפוש, לומר להם לאן הם יכולים להכנס באתר שלנו ולאן לא. מרבית מנועי החיפוש יודעים לקרוא את פקודות הבסיס בלבד בקובץ הנ"ל, אך ישנם מנועי חיפוש אשר יודעים אף לקרוא פקודות נוספות.

במדריך הבא נסביר, נציג ונדגים כיצד על קובץ הrobots.txt להראות, ממה הוא מורכב וכיצד מעלים אותו לאתר שלנו.

מה זה קובץ robots.txt

הקובץ הנ"ל הוא קובץ שנקרא על ידי העכבישים / הזחלנים של מנועי החיפוש. אותם זחלנים נקראים גם "רובוטים" ומכך מקור השם של הקובץ.

הקובץ הנ"ל משמש מעין הוראות כניסה לאותם רובוטים עבור האתר שלנו. לפני שהם נכנסים לאתר, הם סורקים את קובץ ה- robots.txt וממנו מסיקים לאלו דפים מותר להם להכנס ולאילו לא.

על כן, חשוב מאוד להקפיד שקובץ ה- robots.txt יהיה כתוב בצורה נכונה ומדויקת. אין מקום לטעויות.

איפה קובץ ה robots.txt ממוקם

קובץ הרובוטס אמור להיות בתיקיית האב הראשית של הדומיין שלכם. כלומר, אם למשל האתר שלנו הוא

https://www.a-designer.co.il, הגישה לקובץ הרוטובס צריכה להיות כך https://www.a-designer.co.il/robots.txt

- קובץ הrobots.txt חייב להיות קרוי "robots.txt" ולהיות כתוב באותיות קטנות (הזחלנים רגישים לאותיות קטנות וגדולות).

יתרונות וחסרונות בשימוש של הקובץ robots.txt

יתרון: שליטה בתקציב הזחילה

תקציב הזחילה הינו משך הזמן או כמות הדפים שהזחלנים יסרקו באתר שלכם.

כלומר, בכל כניסה לאתר שלכם, לזחלנים יש תקציב שמוגדר מראש, ולכן אין זה אומר שבכל פעם שהם נכנסים לאתר שלכם, הם יסרקו את כל האתר.

המשמעות של תקציב הזחילה היא אחת – עלינו לנצל בחוכמה את תקציב הזחילה של האתר שלנו, ולא לבזבז אותו.

קובץ ה robots.txt הוא אחד הדרכים העיקריות לשליטה בתקציב הזחילה, שכן אנו מורים לזחלנים לאן להכנס ולאן לא.

רוצים ללמוד עוד על תקציב זחילה? עידן בן אור כתב על כך מאמר מצוין באתר שלו.

חסרון: אי אפשר להסיר דפים מתוצאות החיפוש במידה והם כבר נמצאים שם

הקובץ אמנם מורה לזחלנים לאן להכנס ולאן לא, אך הוא לא יכול לומר למנוע החיפוש, לא לאנדקס (כלומר, לא להציג) את הדף הספציפי הזה, או כתובת ה URL הזו.

לכן, אם אתם רוצים להסיר דף מסוים מתוצאות החיפוש של גוגל, עליכם להשתמש בדרך אחרת שנקראת מטה רובוטס ולתת לדף NOINDEX תג.

חסרון: לא מאפשר חלוקת כח של לינקים

במידה והגדרתם שדף כלשהו לא יכנס לתקציב הזחילה. הכח של הדף, לא עובר לדפים אחרים שכן נכנסים לתקציב הזחילה.

תחביר robots.txt

קובץ הרובוטס מורכב מבלוקים הכוללים את נתיבי האתר שלכם ואת "user-agent".

ובמילים פשוטות, אנחנו מגדירים בכל פעם על אילו כתובות באתר אנחנו מדברים ולזחלנים של אילו מנועי חיפוש אנחנו פונים.

להלן התחביר בקובץ:

- המילה Disallow – לאן אסור להכנס. השארת השורה Disallow ריקה פירושה שמותר לזחלן להכנס לכל מקום.

- המילה Allow – לאן מותר להכנס.

- שימוש בכוכבית "*" פירושה "כולם" – כל קובץ, כל מנוע חיפוש, כל זחלן, כל טקסט שהוא.

- הביטוי User-agent – עבור איזה מנוע חיפוש, ההוראה רלוונטית.

לדוגמה:

User-agent: googlebot

Disallow: /Photo

2 השורות האלו אומרות לגוגל בוט, שאסור לו לקרוא את תיקיית Photo (או קובץ בשם Photo).

דוגמה נוספת:

User-agent: googlebot

/Disallow: /Photo

2 השורות האלו אומרת לגוגל בוט, שאסור לו לקרוא את כל מה שנמצא לאחר הנתיב photo/ (כל הקבצים שבתיקייה וכו').

- שימו לב כי שורות הקוד רגישות לאותיות גדולות וקטנות ולכן במקרה הזה למשל, הזחלנים כן יכולים להכנס לתיקיית photo (בניגוד לתיקיית Photo).

רשימת הזחלנים של מנועי החיפוש השונים

| מנוע החיפוש | תחום | שם הזחלן |

| Baidu | כללי | baiduspider |

| Baidu | תמונות | baiduspider-image |

| Baidu | מובייל | baiduspider-mobile |

| Baidu | חדשות | baiduspider-news |

| Baidu | סרטונים | baiduspider-video |

| Bing | כללי | bingbot |

| Bing | כללי | msnbot |

| Bing | סרטונים ותמונות | msnbot-media |

| Bing | Ads | adidxbot |

| כללי | Googlebot | |

| תמונות | Googlebot-Image | |

| מובייל | Googlebot-Mobile | |

| חדשות | Googlebot-News | |

| סרטונים | Googlebot-Video | |

| AdSense | Mediapartners-Google | |

| AdWords | AdsBot-Google | |

| Yahoo! | כללי | slurp |

| Yandex | כללי | yandex |

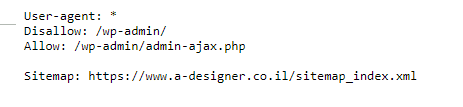

איך קובץ robots.txt צריך להראות בסוף

ניקח את האתר בו אנו משתמשים לדוגמאות www.a-designer.co.il .

נכנס לכתובת ה URL – https://www.a-designer.co.il/robots.txt

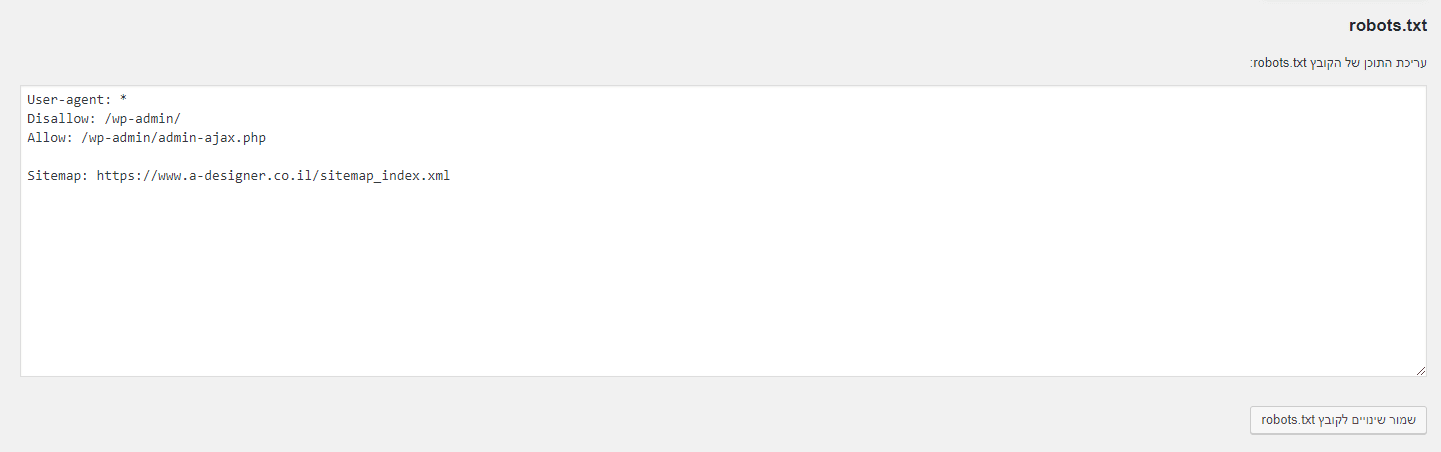

וכך זה יראה:

כך רוב אתרי הוורדפרס, צריכים להראות (אלא אם כן יש משהו מיוחד שדורש שינוי).

פירושן של השורות:

אנו פונים לכלל הזחלנים ואומרים להם, אל תכנסו לWP-ADMIN (פאנל הניהול) למעט admin-ajax.php.

ובשורה האחרונה ניתן לראות את מפת האתר שלנו (SITE MAP), אליה נתייחס במדריך נפרד.

איך ליצור קובץ robotx.txt

על מנת ליצור קובץ robots.txt יש לכם מספר אפשרויות. 2 האפשרויות הנוחות והמוכרות ביותר הן:

- שימוש בפלאגיני SEO – בין אם האתר שלכם מבוסס וורדפרס, WIX, ג'ומלה או כל מערכת מובנת אחרת, ניתן להתקין פלאגין SEO שמכיל גם פיצ'ר של יצירת קובץ רובוטס. בוורדפרס למשל הן YOAST SEO והן RANK MATH ייצרו לכם בקליק אחד קובץ robots.txt איכותי. חשוב לאחר ההתקנה של התוסף, לוודא שאכן נוצר קובץ robots.txt.

- יצירת קובץ robots.txt בצורה ידנית – זה יותר פשוט ממה שאתם חושבים. על מנת ליצור את הקובץ בצורה ידנית עליכם לפתוח במחשב, קובץ TXT פשוט, לשים בו את השורות הרלוונטיות עבורכם, ולאחר מכן להתחבר למנהל הקבצים בשרת שלכם ולהעלות את הקובץ. אנו ניתן דוגמה לכך בהמשך.

איך ליצור קובץ robots.txt עם הפלאגין YOAST SEO

במידה ויש לכם אתר וורדפרס, התקינו את תוסף ה SEO, יוסט. לאחר ההתקנה, בדקו אם נוצר לכם אוטומטית הקובץ. במידה ולא, הכנסו בפלאגין לכלים ->עריכת קבצים -> ייפתח לכם קובץ הרובוטס לעריכה.

איך ליצור קובץ robots.txt בצורה ידנית

- נפתח קובץ TXT חדש במחשב שלנו ונקרא לו robots.

- נעתיק אליו את השורות הנכונות לאתר שלנו:

- User-agent: *

- Disallow: /wp-admin/

- Allow: /wp-admin/admin-ajax.php

- (Sitemap: (sitemap url

- נשמור את הקובץ.

- נתחבר לשרת שלנו (עליו יושב הדומיין).

- נתחבר למנהל הקבצים שלנו (חלק משרתי האחסון, ידרשו ממכם להתחבר דרך חשבון FTP).

- בתיקיית האב הראשית, נוודא כי לא קיים כבר קובץ בשם robots.txt. במידה ולא' נבצע העלאה של הקובץ שיצרנו לתיקייה הזו.

- וזהו – לכם קובץ robots.txt באתר (כמובן שנפתח את https://www.a-designer.co.il/robots.txt ונוודא שאכן זה עובד).

וזהו, יש לנו קובץ robots.

מזל טוב! למדתם כל מה שצריך על קובץ הrobots.txt, זה הזמן לעבור אל שלב מספר 2: חיבור אתר לקלאודפלייר (Cloudflare).

קובץ ה – robots.txt הוא קובץ המכיל הנחיות והוראות לזחלנים של מנועי חיפוש שונים, אילו עמודים באתר הם רשאים לסרוק, ואילו סוגי תכנים הם מורשים בעמודים אלו לאנדקס.

באמצעות שימוש בקובץ ה – robots.txt ניתן לווסת את תקציב הזחילה של מנועי החיפוש באתר, ולייעד את עיקר ההשקעה לעמודים שחשובים יותר לבעל האתר.

את קובץ ה – robots.txt אפשר לייצר בצורה ידנית באמצעות כל עורך טקסט, או לעשות שימוש בפלאגין ייעודי לצורך כך.

היכנסו כעת למאמר השלם ותראו באמצעות דוגמאות כיצד אמור להראות התחביר של הקובץ.